Reflexiones alrededor de la Inteligencia Artificial

Nada de lo que se dice aquí es recomendación de nada. El propósito de este y todos los textos publicados aquí es aclarar mis ideas alrededor de un tópico e intentar tener una conversación constructiva con los lectores

Introducción

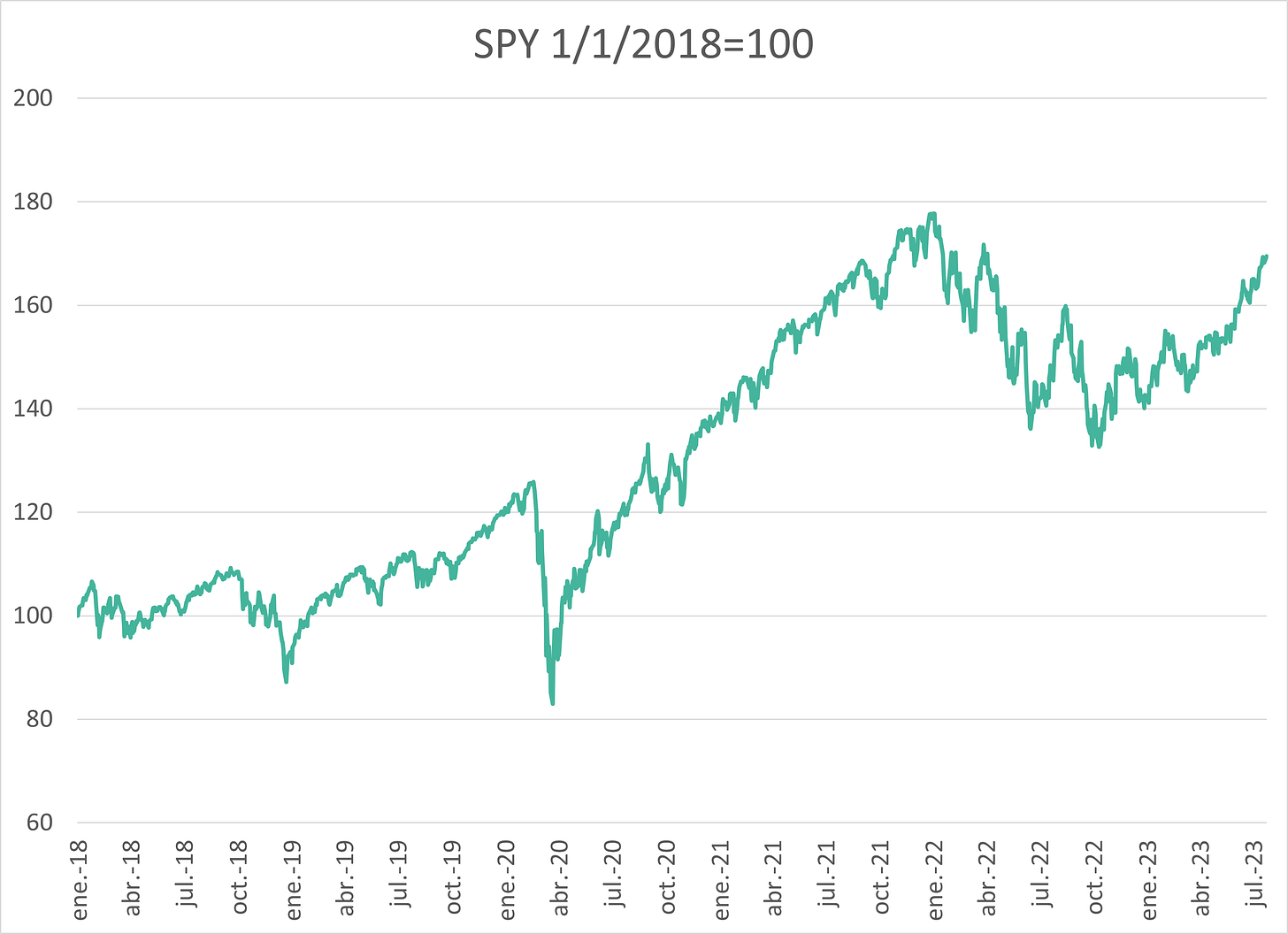

Desde octubre del año pasado, y a medida que se han disipado los temores de una recesión en Estados Unidos. el S&P 500 ha vivido un rally. Este ha sido un rally odidado, según ha reseñado el FT y otros medios.

Hay fundamentalmente dos narrativas en torno a este rally:

La primera es que “8 compañías” (las Big Tech) están detrás de él. Pero como comentó mi amigo Eugenio Deveze, ha reseñado John Authers de Bloomberg, y recientemente han mostrado las acciones de biotech, esto es fundamentalmente falso.

La segunda es que las “compañías de inteligencia artificial” están en una burbuja y eso está detrás del rally. El problema con esta narrativa es que es conceptualmente perezosa y por ende inexacta e inútil. Y es conceptualmente perezosa porque intenta empacar bajo una etiqueta (“inteligencia artificial”) a muchos tipos de compañías que en realidad caben en, al menos, cuatro grandes grupos:

las compañías que son creadoras de inteligencia artificial (como por ejemplo OpenAI o Anthropic);

las compañías usuarias de inteligencia artificial;

las empresas que son tanto creadoras como usuarias de inteligencia artificial (como por ejemplo las Big Tech),

las compañías que crean la infraestructura que la facilita la inteligencia artificial (empresas de chips, centros de datos, GPUs, etcétera).1

El propósito de este post es contribuir a la claridad conceptual en torno a las “compañías de inteligencia artificial”, comentando brevemente sobre los grupos a, c y, d. Dejaré fuera de este comentario a las empresas que son usuarias de inteligencia artificial (b), ya que, como todas las innovaciones, este tipo de empresas se beneficiarán de la tecnología en función de elementos idiosincrásicos. No obstante, a nivel del inversionista activo que busca hacer selección de activos, es importante distinguir entre los grupos a (creadoras) y b (usuarias) de inteligencia artificial. En el contexto actual en el que los equipos de comunicación y estrategia de las compañías buscan subirse al tren de la inteligencia artificial, muchas compañías buscarán presentarse o reciclarse como “compañías que hacen inteligencia artificial”, cuando en realidad son usuarias que pagan a las creadoras por algún servicio.

Este post me deja con la idea (a desarrollarse en un post posterior) de que, la conversación que se debería estar teniendo no es sobre “inteligencia artificial”, sino sobre almacenamiento y procesamiento de datos. La infraestructura que se necesita para hacer que la inteligencia artificial sea posible es, en el fondo, la misma para que los flujos de cualquier tipo de datos (blockchain, gaming, memes, historias en Instagram) sean posibles. Y, dado el ritmo al que está creciendo la producción de datos, las empresas que logren innovar para almacenar y procesar datos de una forma eficiente y ambientalmente sostenible representan se vuelven interesantes. Al final del día, apostar a eficiencia y almacenamiento de datos es apostar en electricidad, por lo que el argumento macro toca a la generación, transmisión, y distribución de energía.

Pure Play

No hay muchas alternativas para hacer una inversión pure play2 a la inteligencia artificial en el mercado de renta variable de Estados Unidos, como señala este post de Josh Brown. Básicamente hay tres compañías listadas que dicen que se dedican a hacer AI exclusivamente. Su desempeño a partir del día en el que se anunció al público la existencia de ChatGPT se muestra a continuación. Si alguien quiere argumentar que hay una “burbuja de AI”, este es el gráfico que hay que mostrar.

Además, en la coyuntura actual, hay ETFs temáticos que previamente ponían énfasis en robótica o automatización pero ahora lo hacen en inteligencia artificial. Este artículo de Motley Fool enumera algunos.

Usuarias y creadoras de AI

Las Big Tech son, simultáneamente, creadoras, usuarias, y proveedoras de infraestructura de inteligencia artificial. Y lo hacen de formas que son complejas de entender, pero en las que al final resultan ser las grandes ganadoras. Tomemos por ejemplo a Microsoft, que es inversionista en OpenAI (la empresa propietaria de ChatGPT), tiene un equipo interno que también está desarrollando sistemas de inteligencia artificial, usa inteligencia artificial para su publicidad, y dentro de sus líneas de negocios (Azure) se encuentra la renta de los GPUs y centros de datos que requieren las empresas de AI (tanto las usuarias como las creadoras) para “almacenar” su información. Google y Amazon son casos similares. Curiosamente, la única Big Tech que no ha anunciado un programa de inteligencia artificial significativo es Apple.

Debido a la multiplicidad de sus negocios, las Big Tech son cada vez más congolomerados modernos y campeones nacionales de Estados Unidos. En ese sentido, su involucramiento en la inteligencia artificial, así como los riesgos regulatorios en torno a esta, es uno más de los elementos para considerar en su valuación.

La infraestructura de AI

Las compañías que crean la infraestructura de AI es un término genérico para empresas que se dedican a fabricar chips; son propietarias o gestionan centros de datos, las líneas físicas y jurídicas de transmisión de datos, etcétera. El caso paradigmático de una empresa dedicada a crear la infraestructura de AI es Nvidia, que básicamente fabrica los chips de las computadoras que procesan la información. Odd Lots de Bloomberg es la mejor fuente de información y opinión sobre la economía de los chips.

Existen varias analogías que sustentan la inversión en las empresas de infraestructura de AI: son “las nuevas carretaras”; “venden las municiones con las que todos los bandos del ecosistema AI pelean por clientes”; “son como los vendedores de palas en el Gold Rush de California en 1849”.

Invertir en la infraestructura de AI no está exenta de riesgos, algunos de los cuales apenas empiezan a ser evidentes y no son del todo intuitivos. Por ejemplo, la demanda de agua para enfriar los centros de datos ya empieza a generar problemas a nivel de las comunidades en algunos países. La compañía de agua que surte agua a Londres ya empieza a racionar el agua a los centros de datos ubicados en esa ciudad. Otro riesgo es la capacidad física para fabricar los chips necesarios que requiere la economía moderna.

Existen indicios de que el espacio de la infraestructura de AI empieza a estar sobre invertido (overcrowded), como este meme.

El chivo expiatiorio detrás de esta narrativa es Nvidia, una compañía que ni siquiera “hace inteligencia artificial”, sino un tipo muy especializado de chips que sirven para un montón de cosas, incluyendo las computadoras que “responden” cuando alguien hace una pregunta en ChatGPT. He puesto en Twitter muchas fuentes explicando qué es, en realidad, Nvidia, algunas de las cuales están en este hilo, y en este video lo explica Damodaran, académico de NYU. Para los interesados en entender qué queremos decir cuando hablamos de inteligencia artificial recomiendo este episodio de Money Talks y esta lectura larguísima de la Enciclopedia de Filosofía de Stanford.

Uso el término pure play para referirme a compañías que dicen que se dedican exclusiva o mayormente a inteligencia artificial, ya sea como usuarias o como creadoras.